Обучение генеративной нейросети под стиль minecraft

Цель проекта — адаптировать генеративную нейросеть Stable Diffusion под узнаваемый визуальный стиль игры Minecraft, с акцентом на специфический стиль — кубические форы, упрощённой палитры, чёткой модульной структуры и уникальной атмосферы игры.

В качестве направления была выбрана визуальная идентичность, основанная на персонажах и элементах из Minecraft, переработанных под оригинальную художественную стилизацию.

Основная цель — исследовать границу между узнаваемым игровым стилем и его возможными вариациями, созданными ИИ.

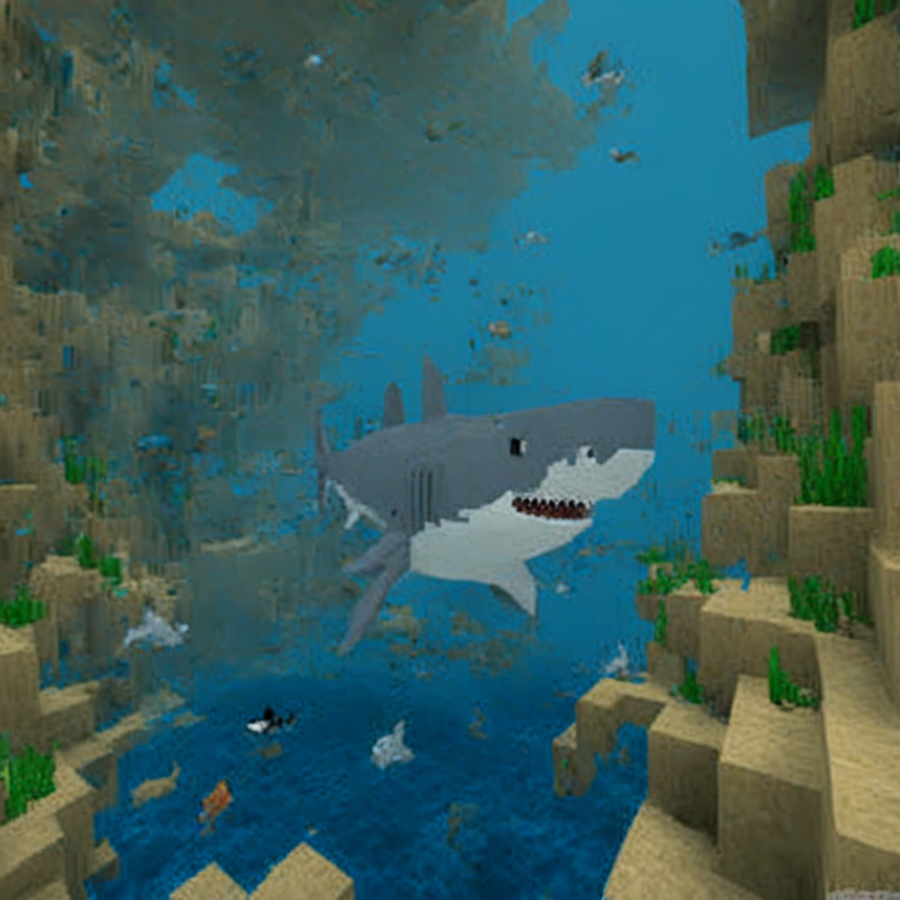

Исходные изображения для обучения (несколько примеров)

Для обучения модели был собран датасет из ~30 квадратных изображений (размером 512×512 пикселей), включающих:

1. Официальные рендеры персонажей с сайта игры Minecraft в разных ракурсах и с различной экипировкой;

2. Объекты игрового мира — деревья, мобы, блоки и предметы, чтобы усилить контекстную узнаваемость;

Изображения были вручную обрезаны и приведены к формату 1:1.

Результат генерации серии изображений

С помощью обученной версии Stable Diffusion была сгенерирована серия изображений, представляющих собой изображения существ, биомов и персонааж игрока в аутентичном окружении.

Развёрнутый комментарий к итоговой серии изображений Итоговые изображения демонстрируют, как обученная модель онтносительно успешно улавливает ключевые элементы майнкрафтовского стиля: строгое следование геометрии, «плиточную» структуру текстур, использование ограниченной палитры. При этом модель способна создавать вариативные сцены и существ, используя полученные паттерны.

Удалось передать:

1. Характерную модульность форм (тела, головы, форма предметов);

2. Простоту генерируемых теней свойственных для игры;

3. Вариативность пространства при сохранении узнаваемой стилистики.

4. Новых существ, не существующих в игре, но выполненых в том же стиле

Ноутбук с кодом для обучения и описание процесса обучения

Модель была обучена с использованием фреймворка Diffusers от HuggingFace на базе модели Stable Diffusion. Обучение проводилось в Google Colab с использованием LoRA (для ускорения и экономии ресурсов).

Основные шаги:

1. Аутентификация

Вход в Hugging Face через notebook_login () для работы с репозиторием модели.

2. Запуск обучения

Скрипт train_dreambooth_lora_sdxl.py запускается с нужными настройками (модель, размер, шаги, скорость обучения и др.).

3. Обучение Модель обучается, сохраняются промежуточные чекпоинты.

4. Сбор модели Создаётся репозиторий, модель оформляется и загружается.

Дополнительно при выполнении проекта использовался СhatGPT, а также GPT-4 для объяснения исходного кода